(3) HDP 구축 및 서비스 배포

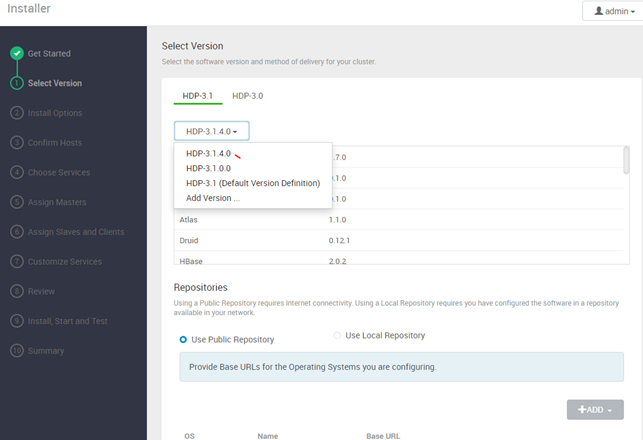

-설치가능한 최신버전인 HDP-3.1.4를 선택후 next

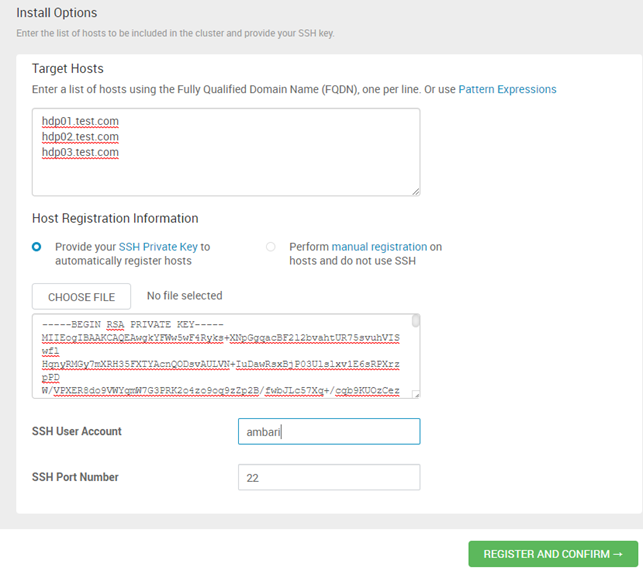

Target hosts는 앞서 설정한 hosts에서 부여한 도메인 주소를 입력

#cat /etc/hostsSSH 공개키를 입력(------BEGIN RSA~~ 부터 ----END ~~ KEY-----까지 모두 다 붙여넣어야함)

#cat ~/.ssh/id_rsaambari 계정 및 포트 입력

이상없이 진행된다면 모든 노드들의 status가 success로 나오고 fail이 뜰 경우 클릭하면 무엇이 문제인지 확인이 가능하다. 그동안 진행한 과정에서 누락 또는 실수로 인한 이슈들이 주로 나올 수 있다.(기본 도구들(자바, 파이썬)의 경로나 방화벽, 권한문제가 있을 가능성이 높음)

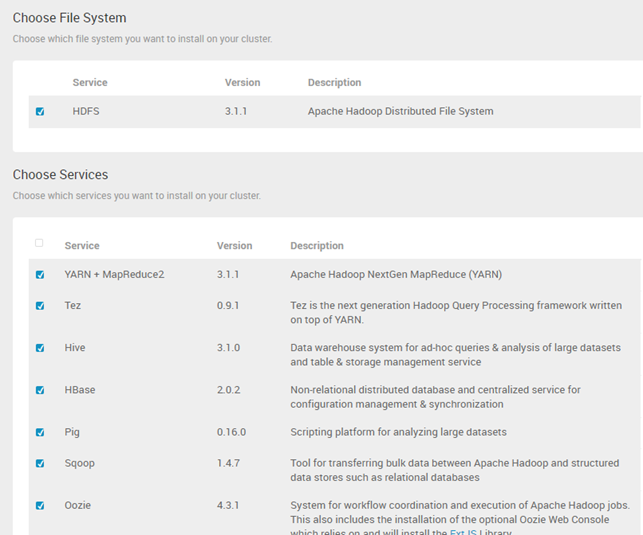

이후 기본 HDFS 위에 원하는 서비스들을 올릴 수 있다. 서비스는 이후에 얼마든지 추가 변경 삭제가 가능하기 때문에 테스트 과정에서는 몇 개만 선택해서 설치함

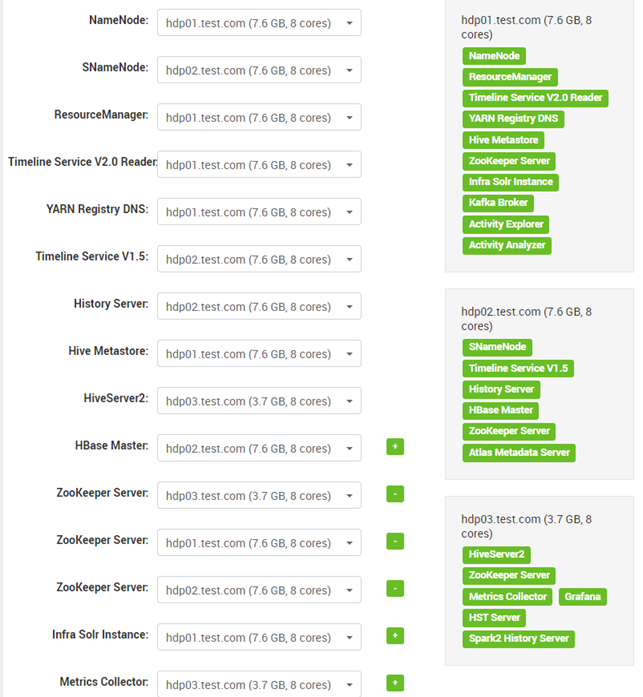

- 서비스 노드의 배치과정에서는 서버들의 노드 수와 스펙에 맞춰 적절히 서비스들을 분산시키자.

- 특히 Hive와 Spark과 같이 서로 의존성이 높은 서비스들은 요구사항을 꼭 확인하고 배치시켜야한다. 이를 위해서는 설치할 서비스에 대한 사전 지식도 반드시 필요할 것이다. (본 테스트과정에서는 무시하고 그냥 설치했음)

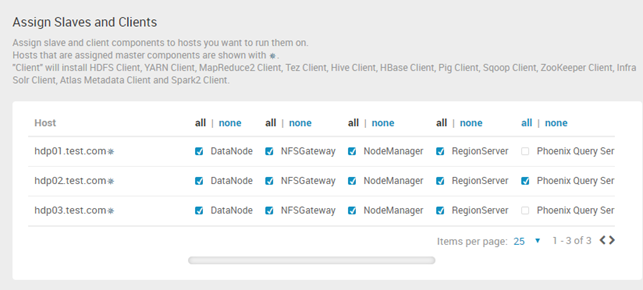

- 각 노드별로 Slaves와 Clients를 할당한다.

- 노드 개수와 HW 스펙에 맞춰 Master와 Slave를 적절히 분배해야 함(이것을 갖추는게 전문가의 길)

- 아래 설정은 테스트로 많은 고민없이 선택된 것임(아주 기본적인 사항으로 Master노드와 Slave 노드는 분리하도록 권고하고있다.)

- 각 서비스별 추가 설정해야할 항목들을 입력해준다. 주로 서비스 계정 설정과 Default DB 정보들을 입력하게 된다.

- 관련된 모든 이슈들을 해결하고 마지막 Deploy를 클릭

- 설치 완료 후 실행에 문제가 있는 서비스 몇 개가 있음을 확인하고 NEXT

- 설치상의 문제가 아니기 때문에 이후에 Trouble shooting하면 됨.

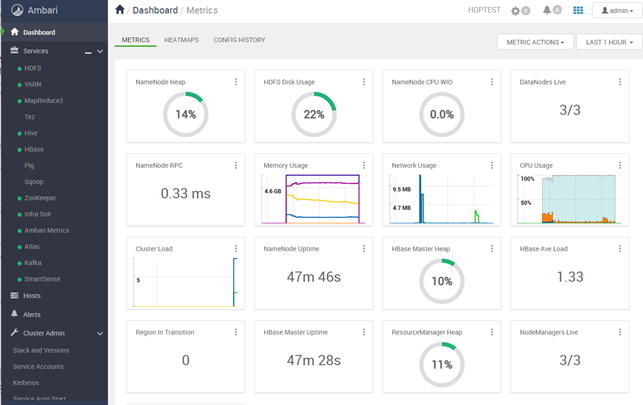

- Ambari 메인 화면에서 모든 서비스가 정상적으로 돌아가는지 확인할 수 있다

: 모든 경고(알람)의 경우 클릭하여 상세 로그를 확인할 수 있음

: 이후 원하는 서비스를 추가 변경 삭제할 수 있음

'Programming > BIG DATA' 카테고리의 다른 글

| Ambari-2.7.4를 활용한 HDP-3.1.4 구축 과정-2 (2) | 2020.04.01 |

|---|---|

| Ambari-2.7.4를 활용한 HDP-3.1.4 구축 과정-1 (0) | 2020.04.01 |

| 아파치 하둡을 위한 하드웨어 추천 관련(펌) (0) | 2015.06.15 |